Me gustó mucho un ensayo reciente publicado en BuzzFeed bajo el título “Donald Trump y el colapso nervioso de Estados Unidos: desbloquear el teléfono en estos días es una pesadilla”, en el que Katherine Miller escribe: “Hay tanto ruido discordante, que distinguir cada cosa individual y darle seguimiento a su recorrido por el ciclo de noticias requiere un enorme esfuerzo. Es difícil orientarse”.

Pensé en ese artículo cuando estaba tratando de decidir cómo cubrir el millón de pequeñas iniciativas que usa Facebook para darle seguimiento a las noticias falsas: es difícil tener todo bajo control y recordar qué es nuevo o qué es simplemente incremental y reconocer los cambios reales en las orientaciones de la empresa.

Farhad Manjoo rastreó algunos de esos cambios en su artículo de portada del New York Times de esta semana, “ ¿Puede Facebook arreglar su peor problema?”. Para esa nota, Manjoo entrevistó varias veces a Mark Zuckerberg. Esto es un extracto de ese artículo:

“Pero la solución al amplio dilema de la mala información –el pernicioso clima de rumores, propaganda y teorías conspirativas que Facebook ha incubado sin darse cuenta– puede requerir algo que nunca ha hecho Facebook: ignorar los likes y los dislikes de sus usuarios. Facebook cree que las noticias inventadas del tipo el-Papa-apoya-a-Trump son solo una pequeña minoría de las piezas que aparecen en News Feed (solo representan una fracción del 1% de los mensajes, según Adam Mosseri, VP a cargo de News Feed). La pregunta que enfrenta la compañía ahora es si el problema de la mala información es más un clickbait, y si sus soluciones se ajustan a la visión del mundo de Facebook. Todo el proyecto de Facebook, cuando se trata de noticias, se basa en la suposición de que las preferencias individuales de las personas coinciden en última instancia con el bien público, y que si no parece así al principio es porque los datos no están siendo estudiados con suficiente profundidad. Décadas de investigación en ciencias sociales muestran, en cambio, que la mayoría de nosotros simplemente preferimos las cosas que se acomodan a nuestra visión del mundo, incluso si no son ciertas en absoluto, y que el uso de esas señales de preferencias probablemente nos meterá aun más adentro de nuestra burbuja”.

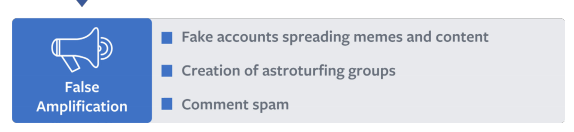

El jueves, Facebook dio a conocer un documento que esboza las nuevas formas en las que la compañía ha “[expandido] nuestro enfoque de la seguridad más allá del tradicional comportamiento abusivo, como el hakeo de cuentas, malware, spam y las estafas financieras, para incluir formas más sutiles e insidiosas del mal uso, incluyendo intentos de manipular el discurso cívico y engañar a la gente”. El documento se enfoca en particular en la ‘falsa amplificación’.

“Las falsas cuentas amplificadoras se manifiestan de formas distintas en todo el mundo y en de cada región”, escriben los autores. Sin embargo, “en el largo plazo, estas redes y cuentas no auténticas pueden ahogar a las historias válidas e incluso disuadir a la gente de entrar a la página”. Entre otras cosas, esto puede incluir “la creación de cuentas falsas, a veces en forma masiva”; ‘likes’ o reacciones coordinadas, y…

“la creación de grupos o páginas con la intención específica de difundir noticias o titulares sensacionalistas o muy sesgados, que a menudo distorsionan los hechos para adaptarse a una narrativa específica. A veces, estas páginas incluyen contenido legítimo y sin relación alguna, obviamente para desviar de su propósito real”.

… todo esto coordinado por personas reales, dice Facebook, no por robots.

“Hemos observado que la mayoría de la amplificación falsa en el contexto de las operaciones de información no es impulsada por procesos automatizados, sino por personas coordinadas que se dedican a operar cuentas que no son auténticas. Hemos observado muchas acciones por parte de operadores de cuentas falsas que solo podrían ser realizadas por personas con conocimientos de idiomas y un conocimiento básico de la situación política en los países de destino, lo que sugiere un alto nivel de coordinación y previsión. Algunos de los actores menos calificados pueden incluso proporcionar guías de contenido y proyectos a sus falsos amplificadores, que pueden dar la impresión de automatización”.

Los autores dicen que el alcance de los esfuerzos de la falsa amplificación durante las elecciones presidenciales de 2016 en Estados Unidos fueron “estadísticamente muy pequeños en comparación con todas las visitas relacionadas con cuestiones políticas”. También dicen que se han tomado medidas contra más de 30,000 cuentas falsas en Francia.

El “Proyecto Búho” de Google, anunciado esta semana, está dirigido al contenido ofensivo y/o falso de las funciones de Autocompletar y Fragmentos Destacados. Según Danny Sullivan, de Search Engine Land:

Las búsquedas problemáticas representan sólo una fracción de la corriente general de búsqueda de Google, pero traen a la empresa un montón de mala prensa. “Se siente como un pequeño problema”, le dijo Pandu Nayak a Sullivan. “La gente en Google quedó totalmente asombrada [por la mala prensa]. Es un problema importante, que no habíamos tenido antes”.

Recomiendo leer otro gran artículo de Sullivan de principios de este mes: “Una profunda mirada a la mayor crisis de calidad en la historia de búsqueda de Google”. (Mientras tanto, Klint Finley, en Wired, se pregunta si Google debería estar tratando en primer lugar de dar “una respuesta verdadera”.)

Una encuesta del Instituto de Política de la escuela Kennedy de la Universidad de Harvard incluyó a 2,654 estadounidenses entre 18 y 29 años, encontrado que, en promedio, piensan que el 48,5% de las noticias que aparecen en Facebook son falsas. Y “los republicanos creen que hay más (56%) ‘noticias falsas’ en su página, en comparación con lo que piensan los demócratas (42%) y los independientes (51%)”.

Esto es un poco loco. Volviendo al artículo de Farhad Manjoo en la parte superior de este post: Facebook cree que solo 1% de las noticias en su News Feed es falsa. Volviendo a Miller de BuzzFeed: “Tratar de determinar la verdad en medio de las complejidades de los protocolos, reglamentos, legislación, ideología, fuentes anónimas, informes contradictorios, negaciones, declaraciones públicas, sus tuits… es demasiado. ¡No podemos vivir así!”

The Spanish version of this story was translated by Univision.