Niejeden inteligentny człowiek ma spore kłopoty z krytyczną analizą źródeł wiadomości. Sam Wineburg i Sarah McGrew z Uniwersytetu Stanforda postanowili zbadać, jak 10 doktorów historii, 10 zawodowych kontrolerów faktów i 25 studentów poradzi sobie z analizą stron internetowych oraz poszukiwaniem informacji społecznych i politycznych. Oto rezultaty eksperymentu:

Historycy i studenci często dali się wprowadzić w błąd i nie zauważali zmienionych w prosty sposób cech stron internetowych, na przykład nazwy i logo, które przypominały te oficjalne. Badani przeglądali stronę od góry do dołu, próbując ocenić jej wiarygodność bez weryfikacji w innych miejscach sieci. Natomiast kontrolerzy faktów szybko przeglądali daną stronę, od lewa do prawa, aby otworzyć w przeglądarce kolejną kartę i sprawdzić wiarygodność badanej strony w innych źródłach. W porównaniu do pozostałych badanych grup działali szybciej, a wyciągane przez nich wnioski były lepiej uzasadnione.

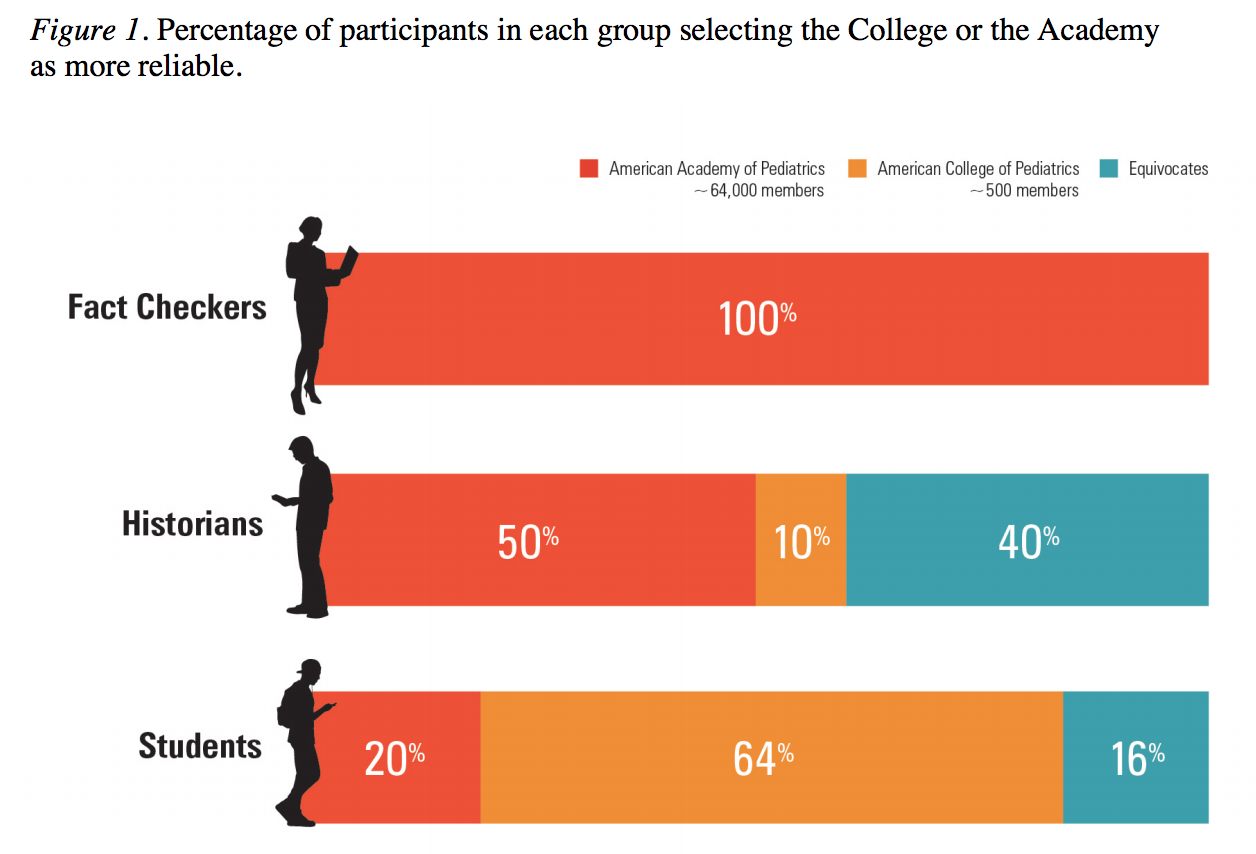

W jednym z ćwiczeń uczestnicy zostali poproszeni o porównanie dwóch artykułów: pierwszy pochodził z serwisu Amerykańskiej Akademii Pediatrii, drugi z Amerykańskiego Kolegium Pediatrów. Nazwy tych dwóch organizacji brzmią podobnie, zwłaszcza w języku angielskim, lecz tak naprawdę są to dwa różne podmioty:

Założona w 1932 roku Amerykańska Akademia Pediatrii zatrudnia 450 pracowników i zrzesza 64 tys. pediatrów, najwięcej na świecie. Wydaje opiniotwórcze czasopismo „Pediatria”, prowadzi szeroką działalność edukacyjną w wielu tematach – od zespołu nagłej śmierci łóżeczkowej niemowląt po podkreślanie konieczności używania kasków rowerowych przez młodzież w okresie dojrzewania. Amerykańskie Kolegium Pediatrów natomiast to odłam akademii, który wyodrębnił się w 2002 roku w związku z różnicą zdań w kwestii adopcji dzieci przez małżeństwa jednopłciowe. Szacuje się, że do wspomnianego kolegium należy od 200 do 500 pediatrów, a zatrudniony jest tam jeden pełnoetatowy pracownik. Organizacja nie wydaje żadnego czasopisma. Od lat spotyka się miażdżącą krytyką środowiska w związku z agresywnym antygejowskim stanowiskiem i poparciem dla tak zwanej „terapii rehabilitacyjnej” dla nieletnich, obecnie prawnie zakazanej w dziewięciu stanach. Postulaty Amerykańskiego Kolegium Pediatrów są również bardzo prowokacyjne. Jednym z przykładów jest poparcie dla zmiany skrótowca LGBT poprzez dodanie litery „P” (jak w słowie „pedofil”). Kolegium twierdzi również, że pedofilia jest na stałe wpisana w program środowisk LGBT.

Organizacja ta nie ukrywa swych poglądów, a jednak studenci w zdecydowanej większości oceniali jej stronę internetową jako bardziej wiarygodną. Podobnie myślała całkiem spora część historyków.

– Obie strony internetowe wydały mi się godne zaufania. Podobał mi się interfejs strony kolegium. Wiarygodność oceniam jednak na tym samym poziomie. Obie organizacje wywodzą się z uczelni lub instytucji, które na co dzień zajmują się tematami związanymi z pediatrią – mówi jeden ze studentów. – Fajnie, że nie ma na stronie kolegium żadnych reklam. Dzięki temu sprawia wrażenie o wiele bardziej rzeczowej – dodaje.

Praca badaczy z Uniwersytetu Stanforda jest bardzo interesująca i świetnie się ją czyta. To najlepsza rzecz, na jaką można się natknąć w temacie świadomego korzystania z technologii cyfrowych. Zwłaszcza ostatni rozdział, poświęcony programom szkolnym uczącym krytyki źródeł, jest wart przeczytania. Założenia, na których te programy się opierają, mogą zawierać sporo błędów.

Większość pozostałych artykułów skupia się albo na mniej istotnych opiniach młodszych uczniów, albo na problemie krytycznej analizy źródeł. Natomiast autorzy omawianych badań kładą nacisk na heurystykę, czyli umiejętności wykrywania nowych faktów i znajdowania związków między nimi. Nie są to umiejętności trudne do wytłumaczenia oraz nauczenia się, nie powinno być również kłopotu z dołączeniem elementów heurystyki do szkolnych programów. Pracę Sama Wineburga i Sary McGrew naprawdę warto przeczytać.

Czy Facebook może pomóc użytkownikom, aby działali w sieci jak profesjonalni kontrolerzy faktów?

Shane Greenup uważa ostatnio wprowadzoną przez Facebooka funkcję, która dodaje kontekst do linków, za wyjątkowo dobre posunięcie. Pomoże ona w czytaniu stron internetowych poziomo, czyli tak, jak rekomendują badacze z Uniwersytetu Stanforda. – Facebook może naprawdę wprowadzić bardzo wartościową funkcję, trudną do naśladowania przez innych, a zarazem wystarczająco otwartą na wybór użytkownika, bez konieczności sugerowania ludziom, co jest prawdą, a co nie – mówi Greenup.

A teraz trochę gorzkich słów o Facebooku.

Facebook ukrywa dane, które wskazywały, jak rozprzestrzenia się dezinformacja.

Czy doszło do utajnienia informacji, czy może błąd systemu pojawił się w budzącym podejrzenie momencie? Niedawno można było przeczytać o tym, jak Johnatan Albright, z zajmującego się zmianami w dziennikarstwie cyfrowym instytutu Tow Center, określił skalę przesyłania nieprawdziwych informacji o wyborach prezydenckich w USA przez posiadaczy fałszywych rosyjskich kont internetowych. Mowa o sześciu wygasłych obecnie kontach. Ustalenia Albrighta dowodzą istnienia setek milionów powielonych fałszywych informacji.

Albright skorzystał z należącego do Facebooka narzędzia o nazwie CrowdTangle, które służy do badania zasięgu publikacji treści w mediach społecznościowych. Niewiele później Facebook usunął z Internetu tysiące postów i prawie wszystkie dane związane z dochodzeniem Albrighta, co zauważył dziennikarz “Washington Post” Craig Timberg. Mówiąc krótko, ani Albright, ani jakikolwiek inny badacz nie był w stanie przeprowadzić takiej analizy raz jeszcze. Na łamach “Washington Post” głos w tej sprawie zabrał związany z uniwersytetem George’a Washingtona profesor Dave Karpf. Sugerował ostrożność, co do ustaleń śledztwa Johna Albrighta, ponieważ dane pochodzące z CrowdTangle niełatwo zanalizować. Profesor podkreślił jednak, że nie lubi sytuacji, gdy znikają wszystkie dane. Zwłaszcza, gdy traci się je w połowie szczegółowych badań.

Facebook tłumaczył, że jedynie „zidentyfikował i naprawił błąd systemu w narzędziu CrowdTangle, który pozwalał użytkownikom na dostęp do informacji z pamięci podręcznej w nieaktywnych stronach serwisu społecznościowego”. Interesująca była jednak sekwencja czasowa tych wydarzeń. W tym samym czasie Sheryl Sandberg, dyrektor operacyjna internetowego giganta z Redmond, powiedziała “Washington Post”:podczas kampanii prezydenckiej w USA w 2016 roku na naszej platformie internetowej wydarzyły się rzeczy, które nie powinny mieć miejsca i zrobimy wszystko, aby doprowadzić do porażki Rosji, a Facebook jest winny Stanom Zjednoczonym nie tylko przeprosiny, ale i zdecydowaną pomoc w działaniu. Słowa były wypowiedziane w związku z pozwoleniem dla Rosji na wtrącanie się w wewnętrzne sprawy USA.

Takeaways of Sandberg interview @mikeallen @axios today:

First off, basically no question was answered. Lots of scripted talking points /1

— Molly McKew (@MollyMcKew) October 12, 2017

It’s backed up. https://t.co/B5SUgWEsg9

— J0nathan A1bright (@d1gi) October 12, 2017

W międzyczasie politycy mają zamiar upublicznić 3 tys. rosyjskich ogłoszeń reklamowych. Nastąpi to po planowanych na 1 listopada przesłuchaniach w sprawie roli portali społecznościowych podczas rosyjskiej ingerencji w amerykańskie wybory prezydenckie. Cecilia Kang z “The New York Times” pisze, że „to oraz podobne przesłuchanie, które senacka komisja do spraw wywiadu ma zamiar przeprowadzić z udziałem przedstawicieli Facebooka, Twittera i Goggle’a, postawi w centrum uwagi te największe firmy z Doliny Krzemowej. Tym bardziej, że ich postrzeganie zmienia się w Waszyngtonie na coraz mniej korzystne”.

Facebook jest zadowolony z pracy swojego zespołu kontrolerów faktów.

Natomiast serwis BuzzFeed opublikował wewnętrzną korespondencję pomiędzy jednym z dyrektorów firmy z Redmond, a jej partnerem zajmującym się kontrolowaniem pojawiających się w Internecie treści:

Dokładnie analizowaliśmy dane przez ostatnich kilka tygodni. Nauczyliśmy się, że jeżeli otrzymamy jedną złą ocenę od jednego z naszych partnerów od sprawdzania faktów, to możemy ograniczyć kolejne wyświetlenia danej wiadomości na Facebooku o około 80 procent. Jesteśmy zbudowani tą skutecznością. Wiemy jednak, ile pracy przed nami. Przede wszystkim chcemy szybciej wykrywać nieprawdziwe informacje. Z reguły zajmuje to trzy dni, a wiemy, że większość wyświetleń następuje właśnie wtedy. Wiemy również, jak wiele fałszywych wiadomości nam umyka, powinniśmy więc zwiększyć ich wykrywalność.

The Polish version of this story was translated by Outriders.